Gütekriterien quantitative forschung: verständlich erklärt

Die Gütekriterien der quantitativen Forschung sind das A und O für glaubwürdige wissenschaftliche Arbeit. Man kann sie als das Fundament sehen, auf dem jedes verlässliche Ergebnis steht. Die drei zentralen Säulen sind hier Objektivität, Reliabilität und Validität. Sie stellen sicher, dass unsere Forschungsergebnisse nicht einfach nur Zufall, Messfehler oder die persönliche Meinung eines Forschers widerspiegeln.

Das qualitätssiegel für ihre forschung verstehen

Stellen Sie sich kurz vor, Sie möchten ein neues Auto kaufen. Vermutlich würden Sie kein Modell wählen, das nicht durch eine strenge Sicherheitsprüfung wie den TÜV gekommen ist, oder? Dieses Siegel gibt Ihnen die Sicherheit, dass das Fahrzeug nach objektiven, nachvollziehbaren Standards geprüft wurde und zuverlässig ist. Genau diese Rolle übernehmen die Gütekriterien in der quantitativen Forschung – sie sind das TÜV-Siegel für Ihre Studie.

Diese Kriterien sind also kein lästiger, bürokratischer Ballast, sondern das entscheidende Qualitätsversprechen Ihrer Arbeit. Sie belegen, dass die erhobenen Daten und die daraus abgeleiteten Schlussfolgerungen Hand und Fuß haben. Ohne sie wäre eine Studie letztlich nicht mehr als eine Sammlung von Behauptungen ohne Beweiskraft.

Warum gütekriterien so entscheidend sind

In der quantitativen Forschung geht es immer darum, mit Zahlen und statistischen Daten Hypothesen zu prüfen und Muster aufzudecken. Das ist ein ganz anderer Ansatz als in der qualitativen Forschung, wo es eher um tiefgreifendes Verstehen und Interpretieren geht. Wenn Sie mehr über diesen grundlegenden Unterschied wissen möchten, finden Sie hier eine detaillierte Gegenüberstellung: Unterschied zwischen qualitativer und quantitativer Forschung.

Die Gütekriterien geben unseren Zahlen erst ihre wirkliche Bedeutung. Im Kern beantworten sie drei ganz einfache, aber entscheidende Fragen:

- Objektivität: Sind meine Ergebnisse unabhängig davon, wer die Studie durchführt oder auswertet?

- Reliabilität: Bekomme ich dasselbe Ergebnis, wenn ich die Messung unter den gleichen Bedingungen wiederhole?

- Validität: Messe ich überhaupt das, was ich messen will?

Diese drei Kriterien bauen aufeinander auf. Man kann es sich wie eine Pyramide vorstellen: Ohne eine objektive Basis ist keine zuverlässige Messung (Reliabilität) möglich. Und ohne eine zuverlässige Messung kann man nicht sicher sein, auch wirklich das Richtige zu messen (Validität). Die Validität ist dabei die Spitze und das wichtigste Kriterium von allen.

Schon seit den 1960er-Jahren gelten diese drei Prinzipien im deutschsprachigen Raum als der Goldstandard. Sie sind fest in den methodischen Standardwerken verankert und bilden den Rahmen für jede ernstzunehmende empirische Untersuchung. Auch das Methodenportal der Universität Leipzig bezeichnet Objektivität, Reliabilität und Validität ganz klar als die „drei Hauptgütekriterien“.

Die drei hauptgütekriterien im überblick

Diese Tabelle bietet eine schnelle Zusammenfassung der drei zentralen Gütekriterien, ihrer Bedeutung und der Kernfrage, die sie jeweils beantworten. Nutzen Sie sie als Kompass für die folgenden, detaillierteren Erklärungen.

| Gütekriterium | Bedeutung (vereinfacht) | Kernfrage |

|---|---|---|

| Objektivität | Unabhängigkeit der Ergebnisse von Forschenden | Kommen andere Forschende zum selben Ergebnis? |

| Reliabilität | Zuverlässigkeit und Beständigkeit der Messung | Ist die Messung bei Wiederholung stabil? |

| Validität | Gültigkeit der Messung und der Ergebnisse | Messe ich wirklich das, was ich messen will? |

Im Grunde geht es darum, Vertrauen in die eigenen Daten zu schaffen. Jedes Kriterium beleuchtet dabei einen anderen Aspekt der Vertrauenswürdigkeit.

Objektivität: Das fundament für neutrale ergebnisse

Nach dem ersten Überblick über die Gütekriterien zoomen wir jetzt auf die erste und wohl grundlegendste Säule heran: die Objektivität. Man kann sich das Ganze wie einen Schiedsrichter im Sport vorstellen. Seine Aufgabe ist es, unparteiisch zu sein und das Spiel fair zu leiten, ohne auch nur den Anschein zu erwecken, ein Team zu bevorzugen.

Genau das ist die Rolle der Objektivität in Ihrer Studie. Die Ergebnisse dürfen nicht von der Person abhängen, die die Daten erhebt, auswertet oder interpretiert. Persönliche Meinungen, Erwartungen oder sogar die Tagesform des Forschers haben hier nichts zu suchen.

Die ultimative Probe: Könnte ein anderer Wissenschaftler mit genau Ihren Methoden und Daten exakt zu denselben Ergebnissen kommen? Wenn ja, dann ist Ihre Studie objektiv und damit wissenschaftlich belastbar.

Die drei facetten der objektivität

Um das zu gewährleisten, schaut man sich die Objektivität in der Praxis aus drei verschiedenen Blickwinkeln an. Jeder dieser Aspekte sichert eine andere Phase des Forschungsprozesses gegen subjektive Einflüsse ab.

- Durchführungsobjektivität: Hier geht es um die Datenerhebung selbst. Laufen die Befragungen oder Messungen für alle Teilnehmenden unter exakt den gleichen Bedingungen ab? Der Forscher muss sich wie ein neutraler Testleiter verhalten, der für alle die gleichen „Spielregeln“ sicherstellt.

- Auswertungsobjektivität: Dieser Punkt greift, sobald die Daten vorliegen. Die Analyse darf keinen Raum für persönliche Interpretationen lassen. Sie muss nach festen, unmissverständlichen Regeln ablaufen, fast wie nach einem Kochrezept.

- Interpretationsobjektivität: Selbst wenn die Durchführung und Auswertung standardisiert waren, könnten die Schlussfolgerungen noch subjektiv gefärbt sein. Deshalb müssen auch die gezogenen Schlüsse nachvollziehbar und klar begründet sein, anstatt auf vagen Vermutungen zu basieren.

Diese Dreiteilung ist ungemein praktisch, weil sie hilft, potenzielle Fehlerquellen ganz gezielt aufzuspüren und auszuschalten. Im Grunde geht es darum, ein so klares Protokoll zu erstellen, dass jeder andere Forscher es eins zu eins nachvollziehen und wiederholen könnte.

Objektivität im Praxistest: Stellen Sie sich den Unterschied zwischen einem lockeren, unstrukturierten Interview und einer Online-Umfrage vor. Im Interview können die Art der Fragen, die Körpersprache oder spontane Nachfragen des Interviewers die Antworten massiv beeinflussen – die Objektivität ist gering. Eine standardisierte Online-Umfrage, bei der jeder Teilnehmer exakt dieselben Fragen in derselben Reihenfolge sieht, hat dagegen eine sehr hohe Durchführungsobjektivität.

Wie sie für objektivität in ihrer forschung sorgen

Die gute Nachricht ist: Objektivität ist kein Zufallsprodukt. Sie können sie durch saubere Planung und klare Regeln gezielt herstellen und absichern. Das Zauberwort lautet Standardisierung.

Hier sind ein paar bewährte Hebel für die drei Bereiche:

Für die Durchführungsobjektivität:

- Setzen Sie auf standardisierte Fragebögen oder etablierte Messinstrumente.

- Schaffen Sie für alle Teilnehmenden eine identische Testsituation (gleicher Raum, gleiche Anleitung, keine Störungen).

- Falls Interviewer oder Testleiter zum Einsatz kommen: Schulen Sie diese intensiv, damit sie sich penibel an das vorgegebene Skript halten.

Für die Auswertungsobjektivität:

- Nutzen Sie vor allem geschlossene Fragen mit festen Antwortoptionen (z. B. Skalen von 1-5, Multiple Choice).

- Erstellen Sie ein detailliertes Codebuch, das genau vorschreibt, wie offene Nennungen zu kategorisieren sind.

- Verwenden Sie Statistiksoftware wie SPSS oder R, die Daten immer nach denselben, festen Algorithmen verarbeitet.

Für die Interpretationsobjektivität:

- Ordnen Sie Ihre Ergebnisse mithilfe etablierter Normwerte oder Vergleichsgruppen ein.

- Eine gute Praxis ist, die Ergebnisse von mehreren Forschern unabhängig voneinander deuten zu lassen und die Interpretationen abzugleichen.

- Beziehen Sie Ihre Schlussfolgerungen immer direkt auf die statistischen Kennzahlen und widerstehen Sie der Versuchung, über die Datenlage hinaus zu spekulieren.

Wenn Sie diese Punkte beachten, bauen Sie ein stabiles, objektives Fundament. Und genau das ist die zwingende Voraussetzung, um sich dem nächsten wichtigen Gütekriterium der quantitativen Forschung widmen zu können: der Reliabilität.

Reliabilität: Wie zuverlässig ist Ihre messung wirklich?

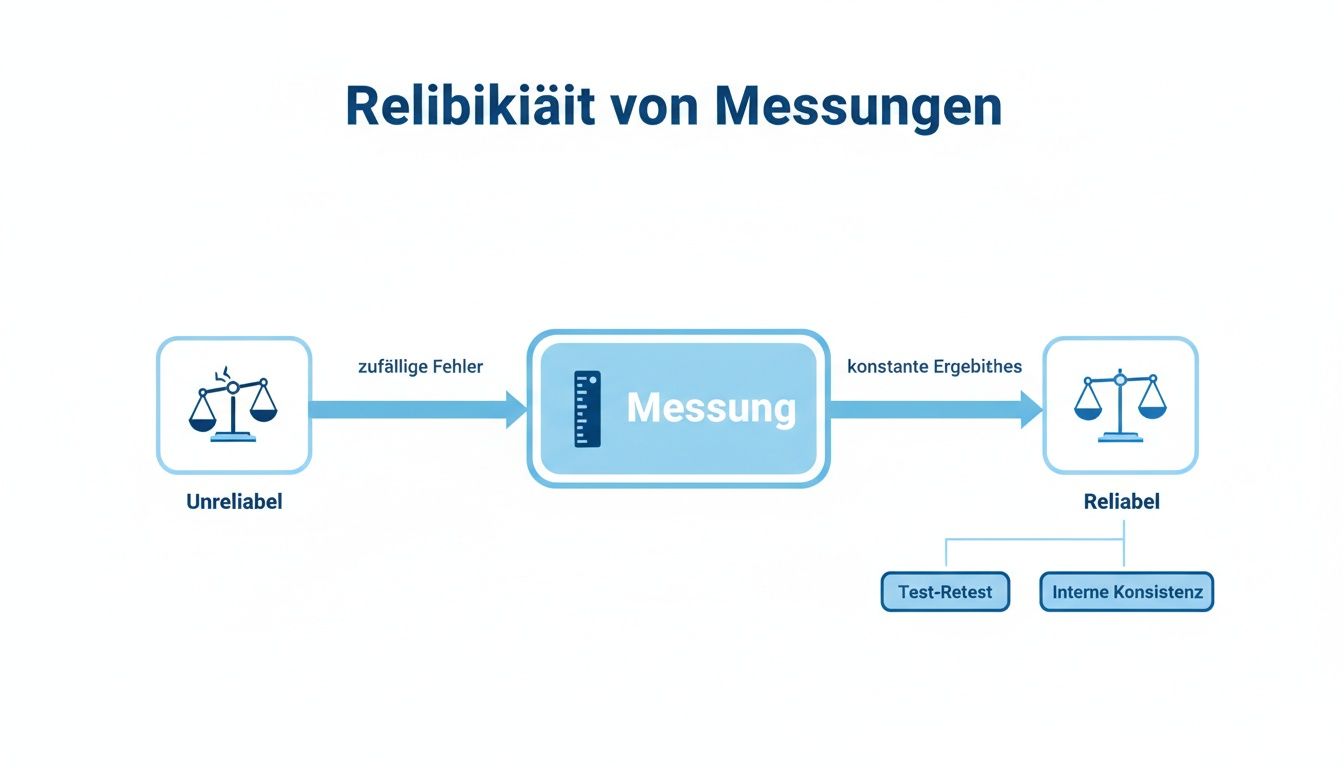

Nachdem wir uns mit der Objektivität beschäftigt haben – also der Frage, ob unsere Ergebnisse unabhängig vom Forschenden sind – kommt nun der nächste entscheidende Baustein guter quantitativer Forschung ins Spiel: die Reliabilität. Hier geht es um die pure Zuverlässigkeit und Beständigkeit Ihrer Messung.

Stellen Sie sich eine einfache Personenwaage vor. Wenn Sie dreimal hintereinander draufsteigen und die Anzeige jedes Mal wild schwankt – mal 75 kg, dann 79 kg und schließlich 72 kg – würden Sie dieser Waage wohl kaum vertrauen. Sie ist nicht reliabel. Ihre Ergebnisse sind inkonsistent und von Zufall geprägt.

Genau dieses Prinzip lässt sich auf wissenschaftliche Instrumente wie Fragebögen oder Tests übertragen. Eine reliable Messung liefert unter gleichbleibenden Bedingungen immer wieder sehr ähnliche oder sogar identische Ergebnisse. Sie ist also weitgehend frei von zufälligen Messfehlern.

Wie prüft man die zuverlässigkeit einer messung?

Um die Reliabilität nicht nur zu behaupten, sondern handfest zu belegen, gibt es etablierte statistische Verfahren. Diese Methoden sind wie Qualitätschecks, die auf unterschiedliche Weise prüfen, wie konsistent Ihr Messinstrument arbeitet.

Welche Methode die beste ist, hängt stark von Ihrer Forschungsfrage und den praktischen Möglichkeiten ab. In vielen Studien, gerade im Rahmen von Abschlussarbeiten, hat sich die Messung der internen Konsistenz als der pragmatischste und am weitesten verbreitete Weg erwiesen.

Ganz wichtig: Reliabilität ist die Voraussetzung für Validität. Ein unzuverlässiges Messinstrument kann niemals gültig sein. Wenn Ihre Waage zufällige Zahlen anzeigt (niedrige Reliabilität), kann sie unmöglich Ihr tatsächliches Gewicht korrekt messen (Validität). Eine hohe Zuverlässigkeit ist zwar noch keine Garantie für Gültigkeit, aber sie ist die absolute Grundvoraussetzung dafür.

Methoden zur prüfung der reliabilität

Die folgenden Verfahren gehören zum Standardrepertoire, um die Messzuverlässigkeit zu überprüfen. Jedes hat seine eigenen Stärken und typischen Anwendungsbereiche.

| Methode | Vorgehensweise | Anwendungsbereich | Typischer Kennwert |

|---|---|---|---|

| Test-Retest-Reliabilität | Derselbe Test wird mit derselben Stichprobe zu zwei verschiedenen Zeitpunkten durchgeführt. | Geeignet für stabile Merkmale wie Persönlichkeitseigenschaften, die sich über die Zeit nicht stark verändern. | Korrelationskoeffizient zwischen den beiden Messungen (sollte > 0.8 sein). |

| Paralleltest-Reliabilität | Zwei inhaltlich äquivalente, aber nicht identische Versionen eines Tests (z. B. Test A und Test B) werden derselben Gruppe vorgelegt. | Nützlich, wenn Lerneffekte beim zweiten Testdurchlauf vermieden werden sollen (z. B. bei Wissenstests). | Korrelation der Ergebnisse zwischen den beiden Testversionen. |

| Interne Konsistenz | Misst, wie stark die einzelnen Fragen (Items) eines Fragebogens, die dasselbe Merkmal erfassen sollen, miteinander zusammenhängen. | Standardverfahren für die meisten Fragebogenstudien, die ein Konstrukt (z. B. Stress, Zufriedenheit) mit mehreren Items messen. | Cronbachs Alpha (α). Ein Wert von α > 0.7 gilt als akzeptabel, Werte über 0.8 als gut. |

Die Wahl der Methode ist also keine Geschmackssache, sondern richtet sich nach dem, was Sie messen wollen und unter welchen Bedingungen Sie es tun.

Ein praktisches beispiel: Arbeitsstress messen

Stellen Sie sich vor, Sie entwickeln einen kurzen Fragebogen, der das Stresslevel von Mitarbeitenden erfassen soll. Dieser Fragebogen könnte fünf Fragen enthalten, die alle auf das Konstrukt „Arbeitsstress“ abzielen:

- "Ich fühle mich durch meine Arbeitslast oft überfordert."

- "Nach der Arbeit fällt es mir schwer, abzuschalten."

- "Der Zeitdruck bei meinen Aufgaben ist sehr hoch."

Um die Reliabilität dieses Fragebogens zu prüfen, würden Sie die interne Konsistenz mit Cronbachs Alpha berechnen. Die Logik dahinter ist einfach: Wenn jemand bei der ersten Frage stark zustimmt, sollte er auch bei den anderen Fragen tendenziell zustimmen, denn alle Items sollen ja dasselbe erfassen.

Ein hoher Alpha-Wert, zum Beispiel α = 0.85, wäre ein starker Beleg dafür, dass Ihr Messinstrument zuverlässig ist. Diese eine Zahl ist ein zentraler Qualitätsnachweis, der in keinem guten Methodik-Kapitel fehlen darf.

Die sorgfältige Prüfung der Reliabilität ist ein entscheidender Schritt in jedem guten Forschungsdesign. Sie sichert die Qualität Ihrer Daten und bildet das Fundament für glaubwürdige Schlussfolgerungen, wie sie in diversen Beispielen für empirische Forschung immer wieder gefordert wird. Ohne eine nachweisbar zuverlässige Messung bleiben Ihre Ergebnisse letztlich angreifbar und wissenschaftlich wenig überzeugend.

Validität: Treffen Sie wirklich ins Schwarze?

Nachdem wir die Reliabilität unserer Messung auf ein solides Fundament gestellt haben, klettern wir nun zur Spitze der Gütekriterien-Pyramide: der Validität. Sie ist sozusagen der ultimative Lackmustest für Ihre Forschung und beantwortet die eine, alles entscheidende Frage: Messen Sie tatsächlich das, was Sie messen wollen?

Stellen Sie sich einen Bogenschützen vor. Wenn all seine Pfeile eng beieinander in einem Baum stecken, die eigentliche Zielscheibe aber verfehlt wurde, dann war er zwar sehr reliabel (zuverlässig), aber eben nicht valide. Erst wenn die Pfeile nicht nur dicht beieinander, sondern auch mitten im Bullseye landen, ist die Übung wirklich gelungen.

Die folgende Grafik zeigt noch einmal, warum eine zuverlässige Messung – also das Vermeiden von Zufallsfehlern – die absolut notwendige Basis für jede valide Aussage ist.

Ohne diese Konstanz in den Ergebnissen stochern wir im Nebel. Eine valide Messung ist also immer auch reliabel, aber nicht zwangsläufig umgekehrt.

Die verschiedenen Gesichter der Validität

Validität ist kein schlichter An-Aus-Schalter. Man kann sie sich eher wie ein Mosaik vorstellen, bei dem verschiedene Steine zusammen ein überzeugendes Gesamtbild ergeben. Jede Art der Validität beleuchtet die Gültigkeit Ihrer Forschung aus einem anderen, wichtigen Blickwinkel.

- Inhaltsvalidität: Ist Ihr Messinstrument wirklich vollständig? Wenn Sie die Zufriedenheit mit einem neuen Smartphone messen, reicht es nicht, nur die Akkulaufzeit abzufragen. Sie müssen auch Aspekte wie Kameraqualität, Bedienbarkeit und Design berücksichtigen, um das Thema umfassend abzudecken.

- Kriteriumsvalidität: Besteht Ihr Messergebnis den Realitätscheck? Angenommen, Sie entwickeln einen Eignungstest für Vertriebsmitarbeiter. Dann sollten die Personen mit den höchsten Testwerten später nachweislich auch die besten Verkaufszahlen erzielen. Das externe Kriterium (Verkaufserfolg) bestätigt also die Gültigkeit Ihres Tests.

- Konstruktvalidität: Erfassen Sie tatsächlich das abstrakte Konzept, um das es geht? Dies ist die anspruchsvollste Form. Hier prüfen Sie, ob sich Ihre Messung logisch und erwartungskonform in ein bestehendes Netz aus Theorien und anderen verwandten Konzepten einfügt.

Diese Prüfungen sind keine akademische Haarspalterei. Sie sind Ihre Versicherung, dass die gesammelten Daten nicht nur bedeutungslose Zahlen sind, sondern die Realität akkurat abbilden.

Ein Beispiel aus der Praxis: Kundenloyalität messen

Stellen Sie sich vor, Sie wollen die Kundenloyalität für einen Online-Shop messen. Ein typischer, aber invalider Ansatz wäre, einfach nur die Anzahl der Käufe zu zählen. Ein Kunde könnte oft bestellen, weil die Preise unschlagbar sind, würde aber beim erstbesten Konkurrenzangebot sofort abwandern. Das ist keine echte Loyalität.

Ein valider Ansatz würde stattdessen so aussehen:

- Inhaltsvalidität sichern: Sie sprechen mit Marketing-Experten und wälzen Fachliteratur, um alle Facetten von Loyalität zu verstehen. Schnell wird klar: Es geht nicht nur um Wiederkäufe, sondern auch um die Bereitschaft zur Weiterempfehlung und eine emotionale Verbundenheit mit der Marke. Ihr Fragebogen muss all das abdecken.

- Kriteriumsvalidität prüfen: Sie gleichen Ihre Umfrageergebnisse mit realen Geschäftsdaten ab. Verzeichnen Kunden, die in der Umfrage hohe Loyalitätswerte angeben, über die nächsten sechs Monate tatsächlich eine geringere Abwanderungsrate? Wenn ja, ist das ein starkes Indiz für die Kriteriumsvalidität Ihrer Messung.

Die Konstruktvalidität wäre hier die Meisterprüfung. Dafür müssten Sie nachweisen, dass Ihr ermittelter Loyalitäts-Score positiv mit verwandten Konzepten wie „Kundenzufriedenheit“ korreliert, aber gleichzeitig negativ mit Konzepten wie „Preissensibilität“ – genau so, wie es die Theorie vorhersagen würde.

Wichtig: Interne und externe Validität unterscheiden

Neben der Gültigkeit der reinen Messung gibt es noch zwei übergeordnete Dimensionen, die sich auf die gesamte Studie beziehen. In der deutschen Forschungstradition wird hier sehr sauber zwischen interner und externer Validität getrennt.

- Interne Validität: Bezieht sich auf die Eindeutigkeit Ihrer Schlussfolgerungen innerhalb der Studie. Können Sie wirklich sicher sein, dass der beobachtete Effekt (z. B. gestiegene Kundentreue) auf Ihre Maßnahme (z. B. ein neues Bonusprogramm) zurückzuführen ist und nicht auf irgendwelche Störfaktoren?

- Externe Validität: Hier geht es um die Generalisierbarkeit. Lassen sich Ihre Ergebnisse auf andere Gruppen, Zeiten oder Situationen übertragen? Sind die Erkenntnisse aus Ihrer Stichprobe von Studierenden aus Berlin auch für die breite Bevölkerung in ganz Deutschland relevant?

Beide Aspekte sind für den praktischen Nutzen Ihrer Forschung absolut entscheidend. Eine Studie kann eine perfekte interne Validität haben, ist aber wertlos, wenn sich ihre Ergebnisse nicht auf die Realität außerhalb des Labors übertragen lassen. Insbesondere bei Fragebogenstudien wird die Validität oft eher argumentativ dargelegt als nur mit Kennzahlen, wie Sie in dieser Vertiefung zu Gütekriterien quantitativer Forschung nachlesen können.

Wie Sie die Gütekriterien in Ihrer Arbeit richtig anwenden

Die Gütekriterien Objektivität, Reliabilität und Validität zu kennen, ist die eine Sache. Die wirklich entscheidende Fähigkeit ist aber, dieses Wissen im Methodenteil Ihrer wissenschaftlichen Arbeit überzeugend zu dokumentieren. Es reicht eben nicht, die Gütekriterien der quantitativen Forschung nur zu kennen – Sie müssen schwarz auf weiß beweisen, dass Sie sie auch umgesetzt haben.

Genau hier liegt oft die Hürde. Viele Studierende verstehen die Konzepte zwar, tun sich aber schwer damit, alles präzise und nachvollziehbar zu Papier zu bringen. Dieser Abschnitt soll Ihnen die Brücke von der Theorie zur Praxis bauen und zeigen, wie Sie die Qualität Ihrer Forschung lückenlos belegen.

Gütekriterien im Methodenkapitel verankern

Das Methodenkapitel ist das Herzstück Ihrer Arbeit. Hier legen Sie die Karten auf den Tisch und erklären, wie Sie zu Ihren Ergebnissen gekommen sind. Die Gütekriterien dabei explizit zu nennen, ist kein optionales Extra, sondern ein fundamentaler Beweis für Ihre wissenschaftliche Sorgfalt.

Leider wird das in der Praxis oft vernachlässigt. Eine Auswertung von Artikeln in deutschsprachigen Fachzeitschriften hat gezeigt, dass in über 30 % der Beiträge konkrete Angaben zu Reliabilitätskennwerten fehlten. Die Lektion daraus ist klar: Man muss im Schreibprozess ganz bewusst darauf achten, die Umsetzung der Gütekriterien explizit zu machen.

Am besten verknüpfen Sie die Gütekriterien direkt mit Ihren methodischen Entscheidungen. Zeigen Sie bei jeder Beschreibung Ihres Vorgehens, welche Maßnahme welchem Gütekriterium dient. So wird Ihre Argumentation wasserdicht und lässt keine Zweifel an der Qualität Ihrer Forschung aufkommen.

Checkliste für die praktische Umsetzung

Diese Checkliste soll Ihnen als roter Faden dienen, um die Qualitätssicherung in Ihrem Methodenteil systematisch darzustellen. Die Formulierungsbeispiele können Sie dabei als direkte Inspiration für Ihre eigene Arbeit nutzen.

Objektivität nachweisen

- Durchführungsobjektivität: Lief die Datenerhebung für alle Teilnehmenden unter den exakt gleichen Bedingungen ab?

- Beispielformulierung: „Die Durchführungsobjektivität wurde durch eine standardisierte Online-Umfrage sichergestellt. Alle Teilnehmenden erhielten die exakt gleichen Fragen in identischer Reihenfolge und mit denselben Instruktionen.“

- Auswertungsobjektivität: Ist die Datenauswertung frei von subjektivem Spielraum?

- Beispielformulierung: „Um die Auswertungsobjektivität zu gewährleisten, wurden ausschließlich geschlossene Fragen mit einer 5-stufigen Likert-Skala verwendet. Die Datenanalyse erfolgte standardisiert mit dem Statistikprogramm SPSS Version 28.“

- Interpretationsobjektivität: Sind Ihre Schlussfolgerungen klar an die Daten gebunden oder lassen sie Raum für persönliche Deutungen?

- Beispielformulierung: „Die Interpretation der Ergebnisse erfolgte streng anhand der statistischen Signifikanzwerte (p < .05), um subjektive Deutungen auszuschließen.“

Reliabilität belegen

- Interne Konsistenz: Haben Sie die Zuverlässigkeit Ihrer Skalen mit einem konkreten Kennwert belegt?

- Beispielformulierung: „Die Reliabilität der Skala zur Messung der Arbeitszufriedenheit wurde mittels Cronbachs Alpha überprüft. Der ermittelte Wert von α = .85 deutet auf eine hohe interne Konsistenz des Messinstruments hin.“

- Test-Retest-Reliabilität (falls zutreffend): Wurde die Stabilität der Messung über die Zeit geprüft?

- Beispielformulierung: „Zur Prüfung der Test-Retest-Reliabilität wurde die Messung nach zwei Wochen wiederholt. Die Korrelation zwischen den beiden Messzeitpunkten war mit r = .91 sehr hoch, was für eine stabile Messung spricht.“

Validität argumentativ begründen

- Inhaltsvalidität: Wie haben Sie sichergestellt, dass Ihr Messinstrument das Konstrukt auch wirklich inhaltlich gut abdeckt?

- Beispielformulierung: „Die Inhaltsvalidität wurde dadurch sichergestellt, dass die entwickelten Items auf etablierten Theorien zur Arbeitszufriedenheit von Herzberg (1959) basieren und zusätzlich durch eine Expertenbefragung validiert wurden.“

- Kriteriumsvalidität (falls zutreffend): Gibt es einen nachweisbaren Zusammenhang mit einem relevanten externen Kriterium?

- Beispielformulierung: „Ein starkes Indiz für die Kriteriumsvalidität ist der signifikante negative Zusammenhang zwischen der von uns gemessenen Arbeitszufriedenheit und der tatsächlichen Kündigungsrate im darauffolgenden Quartal.“

Ein zentraler Punkt, um die Gültigkeit der Forschung zu untermauern, ist die präzise Datenerhebung selbst. Ein gutes Beispiel dafür ist, wie man Cortisol richtig messen und die Werte korrekt interpretieren muss – die saubere Anwendung solcher Verfahren ist entscheidend.

Wenn Sie diese Maßnahmen sorgfältig beschreiben, wird Ihr Methodik-Kapitel von einer reinen Ablaufbeschreibung zu einem überzeugenden Qualitätsnachweis. Einen kompletten Leitfaden mit einem durchgehenden Beispiel finden Sie übrigens in unserem Artikel, der Ihnen zeigt, wie die perfekte Methode für Ihre Bachelorarbeit aussehen kann.

Weitere Gütekriterien, die Sie kennen sollten

Neben den drei grossen Säulen – Objektivität, Reliabilität und Validität –, die das Fundament jeder quantitativen Forschung bilden, gibt es noch weitere wichtige Aspekte. Man könnte sie als Nebengütekriterien bezeichnen, aber sie entscheiden oft darüber, ob eine Studie nicht nur methodisch sauber, sondern auch praktisch relevant und aussagekräftig ist. Sie helfen dabei, den wahren Wert einer Forschungsarbeit ganzheitlich zu bewerten.

Denn was nützt eine perfekt valide und reliable Untersuchung, wenn ihre Ergebnisse niemanden interessieren oder sie unverhältnismässig teuer war? Diese zusätzlichen Kriterien sorgen dafür, dass eine Studie auch ausserhalb des akademischen Elfenbeinturms eine Bedeutung hat.

Repräsentativität: die Brücke zur Allgemeinheit

Eines der wichtigsten dieser weiteren Gütekriterien quantitativer Forschung ist die Repräsentativität. Sie beantwortet eine ganz zentrale Frage: Kann ich die Ergebnisse, die ich von meiner Stichprobe bekommen habe, wirklich auf die gesamte Zielgruppe (die Grundgesamtheit) übertragen?

Stellen Sie sich eine Wahlumfrage vor, für die ausschliesslich Studierende in Grossstädten befragt werden. Die Ergebnisse mögen für diese kleine Gruppe extrem genau sein, aber sie sagen absolut nichts über den Willen aller Wählerinnen und Wähler in Deutschland aus. Die Stichprobe spiegelt schlichtweg nicht die Vielfalt der Bevölkerung wider, weshalb die Schlussfolgerungen für die Allgemeinheit wertlos sind.

Eine repräsentative Stichprobe ist wie ein präzises Miniaturmodell der Bevölkerung. Alle wichtigen Merkmale wie Alter, Geschlecht, Bildungsstand und Wohnort müssen darin im gleichen Verhältnis vorkommen wie in der Grundgesamtheit.

Um das zu erreichen, sind grosse, zufällig gezogene Stichproben der Goldstandard. Nur wenn jedes Mitglied der Zielgruppe die gleiche Chance hat, ausgewählt zu werden, lassen sich systematische Verzerrungen minimieren. Das wiederum stärkt die externe Validität Ihrer Studie ganz massiv.

Ökonomie und Nützlichkeit: der Realitätscheck

Zwei weitere Kriterien, die oft Hand in Hand gehen, sind Ökonomie und Nützlichkeit. Sie holen die Forschung quasi aus dem Labor und stellen sie auf den Prüfstand der realen Welt.

- Ökonomie (Wirtschaftlichkeit): Hier geht es darum, ob der Aufwand einer Studie in einem vernünftigen Verhältnis zum erwarteten Erkenntnisgewinn steht. Eine Längsschnittstudie über zehn Jahre mit Tausenden Teilnehmenden mag zwar extrem genaue Daten liefern, ist aber für eine Bachelorarbeit oder eine schnelle Marktanalyse völlig überdimensioniert und schlicht unwirtschaftlich.

- Nützlichkeit (Relevanz): Dieses Kriterium fragt knallhart nach dem praktischen Wert der Forschung. Bringen die Ergebnisse einen konkreten Vorteil? Lösen sie ein reales Problem? Eine Studie, die belegt, dass eine neue Lehrmethode die Lernerfolge von Schülern um 15 % steigert, hat offensichtlich eine hohe Nützlichkeit.

Ein gutes Beispiel für dieses Zusammenspiel ist die Marktforschung. Ein Unternehmen möchte die Kundenzufriedenheit messen. Man könnte jeden einzelnen Kunden persönlich interviewen. Das würde extrem detaillierte Ergebnisse liefern (hohe Validität), wäre aber unglaublich teuer und zeitaufwendig (miserable Ökonomie).

Eine standardisierte Online-Umfrage hingegen erreicht viele Kunden mit wenig Aufwand (hohe Ökonomie) und liefert schnell praktisch verwertbare Daten, um den Service zu verbessern (hohe Nützlichkeit). Der leichte Verlust an Detailtiefe wird hier durch den grossen praktischen und wirtschaftlichen Vorteil locker aufgewogen. Die Kunst guter Forschung liegt eben oft genau darin, die richtige Balance zwischen methodischer Perfektion und praktischer Anwendbarkeit zu finden.

Noch offene Fragen? Die wichtigsten Antworten auf einen Blick

Zum Abschluss wollen wir noch ein paar typische Fragen klären, die im Forschungsalltag immer wieder auftauchen. Betrachten Sie diesen Abschnitt als eine Art Schnell-Check, um die entscheidenden Konzepte rund um die Gütekriterien zu verinnerlichen.

Welches Gütekriterium ist nun das wichtigste?

Wenn es ein Kriterium gibt, das über allen anderen thront, dann ist es die Validität. Man könnte sie als die Königin der Gütekriterien bezeichnen.

Stellen Sie sich das wie bei einem Medikament vor: Eine Tablette kann in der Produktion noch so perfekt und zuverlässig (reliabel) hergestellt werden. Wenn sie aber den falschen Wirkstoff enthält und deshalb nicht gegen die Krankheit wirkt, ist sie im Grunde nutzlos.

Genauso verhält es sich in der Forschung. Eine Messung mag absolut objektiv und wiederholbar sein. Doch wenn sie am Kern der Sache vorbeizielt und nicht das misst, was sie eigentlich messen soll, dann sind die daraus gewonnenen Erkenntnisse wertlos. Objektivität und Reliabilität sind also die fundamentalen Bausteine, aber die Validität ist das Dach, das alles zusammenhält und dem Ganzen einen Sinn gibt.

Kann eine Messung reliabel, aber nicht valide sein?

Ja, absolut. Das ist sogar ein klassisches Problem, dem man immer wieder begegnet. Denken Sie an eine Waage im Badezimmer, die konsequent immer genau zwei Kilo zu viel anzeigt. Sie ist extrem zuverlässig (reliabel) – das Ergebnis ist bei jeder Messung reproduzierbar falsch. Aber sie ist nicht gültig (valide), weil sie nicht Ihr tatsächliches Gewicht misst.

Ein anderes Beispiel aus der Praxis wäre ein Fragebogen, der angeblich die Arbeitszufriedenheit messen soll, aber stattdessen hauptsächlich die allgemeine Lebenszufriedenheit der Mitarbeitenden abfragt. Die Ergebnisse könnten bei Wiederholung sehr stabil sein, aber sie messen eben nicht das, was sie vorgeben zu messen. Die Messung ist also zuverlässig, aber für den eigentlichen Zweck nicht gültig.

Was ist ein guter Wert für Cronbachs Alpha?

Cronbachs Alpha ist das mit Abstand gängigste Maß, um die interne Konsistenz einer Skala zu prüfen – also eine wichtige Form der Reliabilität. In den Sozialwissenschaften haben sich dafür klare Orientierungswerte etabliert, an denen man sich gut halten kann:

- α ≥ 0,9: Ausgezeichnet

- α ≥ 0,8: Gut

- α ≥ 0,7: Akzeptabel

- α < 0,6: Fragwürdig bis unbrauchbar

Ein Wert von 0,7 gilt oft als die magische Untergrenze, die man erreichen sollte. Liegt Ihr Alpha-Wert darunter, ist das ein deutliches Warnsignal. Sie sollten dann dringend prüfen, welche Fragen (Items) in Ihrer Skala aus der Reihe tanzen, weil sie vermutlich nicht dasselbe Konstrukt messen wie die anderen.

Wie hängen interne und externe Validität zusammen?

Diese beiden Validitätsformen stehen oft in einem klassischen Zielkonflikt. Die interne Validität fokussiert sich darauf, ob die Schlussfolgerungen innerhalb der Studie wirklich stimmen. Um sie zu maximieren, versucht man, alle denkbaren Störfaktoren auszuschalten – was oft nur in einer künstlichen, streng kontrollierten Laborumgebung gelingt.

Die externe Validität hingegen stellt die Frage, ob sich die Ergebnisse auf die echte Welt verallgemeinern lassen. Ein strenges Laborexperiment hat daher oft eine hohe interne, aber eine eher schwache externe Validität, weil die künstliche Situation wenig mit dem realen Leben zu tun hat. Umgekehrt hat eine Feldstudie mitten im Geschehen eine hohe externe Validität. Hier leidet aber oft die interne Validität, weil unzählige Faktoren die Ergebnisse beeinflussen, die man gar nicht alle kontrollieren kann.

Gute Forschung ist immer ein Balanceakt. Das Ziel ist es, Störvariablen so gut es geht im Griff zu haben, ohne die Untersuchungssituation so künstlich zu gestalten, dass die Ergebnisse für die Praxis jede Relevanz verlieren.

Letztendlich ist Forschung also immer ein Kompromiss. Die wahre Kunst besteht darin, für die eigene Fragestellung den bestmöglichen Mittelweg zu finden und die getroffenen Entscheidungen transparent zu machen.

Um den Prozess der Literaturrecherche und des wissenschaftlichen Schreibens zu vereinfachen, bietet KalemiFlow intelligente Werkzeuge. Finden Sie relevante Quellen, erstellen Sie präzise Zitationen und strukturieren Sie Ihre Arbeit effizienter auf https://kalemiflow.de.